Der EU AI Act verändert den Umgang mit künstlicher Intelligenz in Unternehmen – auch im Marketing. Was genau in der Verordnung geregelt wird, welche Tools betroffen sind und was Sie jetzt beachten müssen, erfahren Sie hier.

Künstliche Intelligenz ist in den meisten Marketingabteilungen längst Alltag – von Chatbots auf der Website über Text- und Bildgenerierung bis hin zu Automations und Predictive Lead Scoring. Was bisher für viele eine Art Spielwiese für Experimente und – manchmal – Innovationen war, bekommt nun einen verbindlichen Rechtsrahmen, nämlich die KI-Verordnung der Europäischen Union, kurz: den EU AI Act.

Für Marketing-Teams bedeutet dieses weltweit erste KI-Gesetz einen Paradigmenwechsel. Denn nicht nur Anbieter von KI-Tools, sondern auch Anwender sind nun dafür verantwortlich, die Risiken, die mit dem Einsatz künstlicher Intelligenz einhergehen, zu minimieren.

In diesem Artikel erfahren Sie, was genau die EU im AI Act vorschreibt und welche Maßnahmen Sie jetzt ergreifen müssen.

Was beinhaltet die KI-Verordnung der EU?

Die KI-Verordnung der Europäischen Union ist ein Balanceakt: Das hauptsächliche Ziel besteht darin, einen verantwortungsvollen Umgang mit KI-Systemen sicherzustellen, das immense Potenzial der Technologie jedoch gleichzeitig nicht zu sehr einzuschränken.

Ein „KI-System“ definiert der EU AI Act wie folgt:

„Ein KI-System ist ein maschinengestütztes System, das so konzipiert ist, dass es mit unterschiedlichem Grad an Autonomie betrieben werden kann und nach seiner Einführung Anpassungsfähigkeit zeigt, und das für explizite oder implizite Ziele aus den Eingaben, die es erhält, ableitet, wie es Ausgaben wie Vorhersagen, Inhalte, Empfehlungen oder Entscheidungen generieren kann, die physische oder virtuelle Umgebungen beeinflussen können.“

Art. 3 Nr. 1

Darunter fallen nicht nur klassische Machine-Learning-Systeme, sondern auch viele regelbasierte Automatisierungen, wenn sie nicht nur simple Wenn-dann-Prozesse abbilden, sondern eine gewisse Autonomie aufweisen. Damit betrifft das Gesetz deutlich mehr Tools, als man zunächst annehmen könnte, beispielsweise …

- Marketing Automations auf Basis von dynamischem Lead Scoring,

- Empfehlungssysteme oder

- Content Moderation –

Use Cases also, in denen das System mit sich veränderndem Input konfrontiert wird und auf dieser Basis „eine Entscheidung trifft“.

Die Risikokategorien

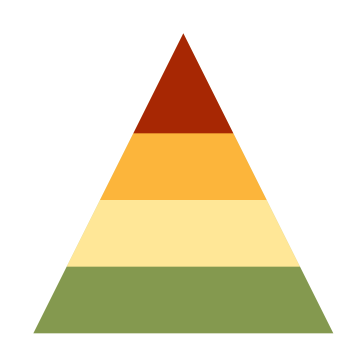

Das Grundkonzept der Verordnung besteht in einer Einteilung von KI-Systemen in vier Risikoklassen:

Unannehmbares Risiko (Art. 5)

Diese KI-Systeme sind verboten. In diese Kategorie fallen KI-Systeme, die genutzt werden könnten für:

- Manipulation (z. B. durch unterschwellige Werbung)

- Ausnutzung von Schwächen (z. B. Alter oder Behinderung)

- Biometrische Kategorisierung (z. B. die Ableitung der politischen Einstellung anhand der Gesichtszüge)

- Social Scoring

- Echtzeit-Gesichtserkennung im öffentlichen Raum zur Strafverfolgung (mit wenigen Ausnahmen)

- Kriminalitätsprognose durch Profiling

- Erstellung von Gesichtserkennungs-Datenbanken durch Scraping von Websites (z. B. Social-Media-Profilen)

- Emotionserkennung am Arbeitsplatz (auch z. B. beim Meeting-Mitschnitt)

Die Strafen können erheblich sein: Bis zu 35 Mio. EUR oder 7 % des weltweiten Jahresumsatzes müssen Unternehmen zahlen, die verbotene KI-Systeme veröffentlichen oder einsetzen (Art. 99–101).

Hohes Risiko (Art. 6–39)

Ein hohes Risiko bergen Anwendungen, die in sensible Bereiche wie Bildung, Personalwesen oder Infrastruktur eingreifen.

Hier einige Beispiele und warum diese KI-Systeme hochriskant sind:

- Gesichtsscan zur Identitätsbestätigung: Was, wenn die KI eine falsche Identität zuordnet?

- Benotung von Klausuren: Was, wenn die KI zu schlecht benotet?

- Screening von Bewerbern: Was, wenn die KI diskriminiert?

- Bearbeitung von Anträgen: Was, wenn die KI ohne plausible Gründe ablehnt?

- Steuerung kritischer Infrastruktur: Was, wenn die KI in wichtigen medizinischen Geräten nicht richtig funktioniert?

Hochriskante KI-Systeme gehen mit Konformitätspflichten einher. Es gelten strenge Anforderungen an Transparenz, Datenqualität, Risikoanalyse und Dokumentation:

- KI-Systeme müssen nachvollziehbare Ergebnisse liefern und frei von Vorurteilen sein.

- Bekannte und vorhersehbare Risiken müssen analysiert, evaluiert und minimiert werden.

- Anbieter müssen eine umfassende Dokumentation bereitstellen.

- KI-Systeme müssen offiziell registriert werden.

- Nutzer müssen über die Funktionsweise des Systems und etwaige Risiken informiert werden.

- Nutzer müssen das System überwachen und eingreifen können.

- Ergebnisse müssen systemseitig protokolliert werden.

- Vorfälle müssen gemeldet und ggf. gemeinsam mit Behörden analysiert werden.

Gerade Hochrisiko-KI-Systeme können sehr nützlich sein und die Produktivität eines Unternehmens deutlich steigern. Worauf es ankommt, ist eine sorgfältige Planung, die Bewertung der Einsatzszenarien durch Experten für KI-Risiken sowie die kontinuierliche Überprüfung des KI-Systems im Hinblick auf die identifizierten Risiken.

Geringes Risiko (Art. 50)

In diese Kategorie fallen vor allem KI-Systeme, die direkt oder indirekt der Kommunikation dienen, zum Beispiel:

- automatisch generierte Medien,

- Chatbots im Kundenservice,

- Übersetzungen,

- Verschlagwortung von Dokumenten.

Für KI-Systeme mit geringem Risiko bestehen in bestimmten Fällen Transparenzpflichten: Nutzer müssen darauf hingewiesen werden, wenn sie mit einem KI-System interagieren (z. B. Chatbot; Ausnahme: wenn dies offensichtlich ist) oder wenn Bild-/Audio-/Video-Inhalte als „Deepfakes“ gelten (also den Eindruck erwecken, die Realität abzubilden).

Für Texte gilt eine Hinweispflicht nur, wenn sie publiziert werden, um die Öffentlichkeit über Angelegenheiten von öffentlichem Interesse zu informieren (wenn es sich also um Nachrichten handelt). Die Hinweispflicht entfällt, wenn der Inhalt redaktionell geprüft wurde und eine Person redaktionelle Verantwortung trägt.

Achtung: Zu eigen macht man sich den Output von KI-Systemen durch die bloße Prüfung nicht! Im Hinblick auf das Urheberrecht können Sie Ansprüche erst geltend machen, wenn Sie die KI-generierten Texte, Bilder oder andere Medien in bedeutendem Maße verändern. (Streng genommen. Denn ein gerichtsfester Nachweis, wie die Arbeit zwischen KI und Mensch bei einem unauffälligen Text aufgeteilt wurde, dürfte in der Regel kaum zu erbringen sein. Dennoch ist es immer empfehlenswert, KI-Output nur als Orientierung oder Grundlage zu verwenden.)

Entscheidend ist, um es zusammenzufassen, dass ein KI-System nicht autonom Inhalte veröffentlichen kann, die Nutzern als menschengemacht und damit (mehr oder weniger) vertrauenswürdig erscheinen.

Einige Ausnahmen gibt es jedoch:

- Offensichtliche KI-Systeme (z. B. Chatbots mit Roboterstimme),

- Strafverfolgung (z. B. mittels Fake-Profil),

- Kunst, Parodie, Satire.

Unternehmen sollten genau prüfen, ob und wann die Pflicht zur Offenlegung greift, insbesondere bei publikumswirksamen Inhalten oder in täuschungsanfälligen Kontexten.

Minimales Risiko

Hier kommt die gute Nachricht für Sie: Viele KI-Systeme, die in Unternehmen genutzt werden, fallen in die Kategorie „Minimales Risiko“ und unterliegen keinerlei Anforderungen seitens der EU.

Minimal riskante KI-Systeme können beispielsweise als Basis dienen für:

- Autovervollständigung in Suchleisten,

- Rechtschreib- und Grammatikprüfung,

- Produktempfehlungen in Onlineshops und

- Spamfilter.

Auch wenn solche Systeme ohne Weiteres eingesetzt werden dürfen, können Unternehmen, die freiwillig Transparenz zeigen, dadurch das Vertrauen von Kunden gewinnen.

Stichtage

Die KI-Verordnung der Europäischen Union tritt schrittweise in Kraft. Das sind die Daten, die Sie sich merken sollten:

- 1. August 2024: Die Verordnung tritt formell in Kraft. Sie ist ab diesem Zeitpunkt geltendes Recht, enthält jedoch noch keine unmittelbar anwendbaren Pflichten für Unternehmen.

- 2. Februar 2025: Erste Anwendungspflichten beginnen – insbesondere das Verbot von KI-Systemen mit unannehmbarem Risiko.

- 2. August 2025: Vorschriften für KI‑Modelle mit allgemeinem Verwendungszweck (General Purpose AI, kurz: GPAI) treten in Kraft. Dazu gehören Dokumentationspflichten und Sicherheitsanforderungen.

- 2. August 2026: Zusätzliche Regelungen für Hochrisiko-KI-Systeme gelten nun verbindlich. Nationale Aufsichtsbehörden müssen eingerichtet sein, außerdem sogenannte „Sandboxes“, also sichere Testumgebungen für KI-Innovationen.

- 2. August 2027: Letzte Übergangsfrist für GPAI-Modelle und Hochrisiko-KI-Systeme, die in bestehende Produktregulierungen eingebettet sind (also z. B. in Maschinensteuerungen oder Medizinprodukte integriert sind). Diese müssen nun ebenfalls vollständig konform sein.

Ein bisschen Zeit bleibt also noch, bevor die KI-Verordnung in Gänze wirksam sein wird. Viele Bestandteile, die für Marketingteams relevant sind, gelten jedoch schon jetzt!

Warum Marketing-Teams besonders betroffen sind

Kaum eine Abteilung hat KI so früh und umfassend in die tägliche Arbeit eingebunden wie das Marketing. Das liegt an mehreren Faktoren: Gutes Marketing zeigt Kreativität, testet immer wieder neue Ansätze und nutzt zahlreiche Tools für Mediengestaltung, Datenanalyse und Prozessautomatisierung. Gerade hier kann generative künstliche Intelligenz – wie in ChatGPT und anderen Systemen, die auf Large Language Models basieren – nützlich sein.

Wie relevant das Thema KI im Marketing ist, lässt sich anhand von Zahlen zeigen: Laut einer Befragung von Salesforce setzten schon im letzten Jahr 75 % der deutschen Marketer KI-Tools ein. Der AI Marketing Benchmark Report 2025 von Influencer Marketing Hub geht ins Detail: Jeder 5. Marketer gibt mindestens 40 % seines Budgets für KI-basierte Kampagnen aus, und 34,1 % der Befragten sprechen von „bedeutenden Verbesserungen“ der Marketingerfolge dank KI.

Nach einer relativ unbeschwerten Anfangsphase – experimentierfreudig, pragmatisch, agil – müssen sich Marketingverantwortliche ab jetzt verstärkt mit rechtlichen Anforderungen auseinandersetzen.

Was bedeutet das zum Beispiel?

- Chatbots auf der Website müssen gekennzeichnet werden,

- Artikel auf Richtigkeit geprüft,

- Deepfakes vermieden,

- KI-generierte E-Mails gegengelesen.

Das sollte selbstverständlich sein.

Doch auch scheinbar harmlose Use Cases wie die Analyse von Dokumenten oder die Übersetzung von Produktbeschreibungen unterliegen nun gewissen Anforderungen.

Für Marketing-Teams markiert der AI Act damit einen bedeutenden Wendepunkt. Wer KI für Unternehmenskommunikation und Werbung nutzen will – und das ist kaum noch vermeidbar –, muss sich mit der Kritikalitätspyramide vertraut machen, evaluieren, welche KI-Systeme in welche Kategorie fallen, und entsprechende Maßnahmen ergreifen.

In einigen Fällen sind nur kleine Anpassungen notwendig, um wie bisher weiterarbeiten zu können. Es kann jedoch auch vorkommen, dass Marketer sich neu orientieren und alternative Lösungen suchen müssen. Wichtig ist, diese Prüfung nicht länger aufzuschieben, sondern so schnell wie möglich für einen rechtskonformen Einsatz aller KI-Systeme zu sorgen.

Wo wird KI im Marketing eingesetzt?

Als Nächstes sollten wir also überlegen: Wo greift der EU AI Act im Bereich Marketing überhaupt? Hier sind einige konkrete Beispiele, die Ihnen bei der Suche helfen könnten, mit den jeweiligen Anforderungen:

- Veröffentlichung von KI-Texten: Beachten Sie die Transparenzpflicht, wenn es sich um Themen von öffentlichem Interesse handelt.

- Automatische Übersetzungen: Aus Übersetzungsfehlern können Probleme entstehen, weshalb eine Kontrolle hier unabdingbar ist.

- Bild- und Videogenerierung: Transparenz kann auch hier erforderlich sein, insbesondere bei KI-Avataren und Deepfakes.

- Stimmungsanalyse von Social-Media-Beiträgen: Automatisierte Sentiment‑Analyse gilt typischerweise als KI-Anwendung mit begrenztem Risiko.

- Chatbot auf der Website: Nutzer müssen darauf hingewiesen werden, dass sie nicht mit einem Menschen, sondern mit einer KI interagieren.

- Personalisierte Produktempfehlungen: Gehören für gewöhnlich in die Kategorie „minimales Risiko“ – das heißt, es gibt keine besonderen Pflichten.

- KI-generierte E-Mails: Es bestehen zwar keine Prüfungs- oder Transparenzpflichten, dennoch sollten Sie keine „KI-Mails“ an Kollegen, Geschäftspartner oder Kunden versenden.

- Analyse von Nutzerverhalten zur Kampagnenoptimierung: Geringes bis hohes Risiko, abhängig von Personenbezug und Verwendungszweck.

Auch wenn viele Marketing-Anwendungen nur ein geringes Risiko bergen, sollten Marketer aufmerksam bleiben: Sobald Inhalte veröffentlicht werden oder sensible Daten im Spiel sind, kann die Risikostufe steigen.

In 9 Schritten zur AI-Act-Compliance

Um den EU AI Act im Marketing-Alltag umzusetzen, empfiehlt sich – wie bei jeder komplexen Angelegenheit – ein strukturierter Ansatz. Die folgenden 9 Schritte helfen Ihnen dabei, alle gesetzlichen Anforderungen zu erfüllen.

1) Verantwortlichkeiten festlegen

Ernennen Sie eine zentrale Ansprechperson – einen KI-Beauftragten – oder ein Team, das sich in Ihrem Unternehmen mit neuen Tools und Gesetzen beschäftigt. Investieren Sie in die Weiterbildung von KI-Verantwortlichen: Das Thema ist zu wichtig, um es halbherzig anzugehen, sowohl im Hinblick auf die rasante Entwicklung der Technologie selbst als auch auf die Compliance mit dem AI Act.

Nutzen Sie bereits eine Plattform für die Aufgabenverwaltung? Falls nicht, sollten Sie spätestens jetzt darüber nachdenken! Indem Sie die Aufgaben, Verantwortlichkeiten und Fristen im Kontext der KI-Verordnung digital und übersichtlich abbilden, vergessen Sie nichts und können bei Audits mit wenig Aufwand eine umfassende Dokumentation aller bisherigen Maßnahmen zusammenstellen.

2) KI-Tools inventarisieren

Welche KI-Tools sind bereits im Einsatz? Chatbots, Text- und Bildgeneratoren, Lead‑Scoring‑Systeme, Übersetzungsdienste? Legen Sie eine Tabelle an mit den Namen der Tools, den Anbietern und den Funktionen, die Sie nutzen.

Wenn Ihre KI-System-Landschaft sich als sehr komplex erweist, können professionelle Inventarisierungstools nützlich sein. Ein Beispiel ist Casebase. Damit können Sie jeden Use Case und jedes Projekt einzeln erfassen und managen.

Wenn Sie nicht sicher sind, ob es sich bei einem eingesetzten Tool um ein „KI-System“ handelt, wie es die KI-Verordnung definiert, können Sie es mit diesem nützlichen Tool überprüfen: EU AI Act Compliance Checker.

3) Risiken bewerten

Betrachten Sie jede einzelne Toolfunktion in Ihrem KI-Inventar und bewerten Sie diese hinsichtlich des Risikos im Sinne der KI-Verordnung (minimales Risiko, geringes Risiko, hohes Risiko, unannehmbares Risiko).

Auch in diesem Schritt ist der EU AI Act Compliance Checker nützlich!

4) KI-Richtlinie erstellen

Definieren Sie verbindliche Regeln für das gesamte Unternehmen: Welche Tools und Funktionen sind erlaubt? Welche Daten dürfen in KI-Systeme eingegeben werden? Wie und wofür darf der Output verwendet werden?

PwC empfiehlt, AI‑Compliance in einen vorhandenen IT-Governance-, Risk-Management- und Compliance-Rahmen (GRC) einzubetten. Auf diese Weise vermeiden Sie widersprüchliche Rechte und Vorgaben.

5) Mitarbeiter regelmäßig schulen

Sensibilisieren Sie Ihr Team für Risiken beim Einsatz von künstlicher Intelligenz und die Vorschriften des AI Acts. Sorgen Sie dafür, dass alle Nutzer von KI-Systemen an einer entsprechenden Schulung teilnehmen und dokumentieren Sie Schulungsinhalte und Teilnahmen.

6) Maßnahmen umsetzen

Wie Sie gesehen haben, erfordert die KI-Verordnung für manche Use Cases von KI-Systemen bestimmte Maßnahmen in Bezug auf Sicherheit oder Transparenz – die Sie so früh wie möglich umsetzen sollten.

Machen Sie beispielsweise deutlich, wenn automatisch veröffentlichte Inhalte ausschließlich oder größtenteils von KI generiert wurden (z. B. durch den Hinweis „Text erstellt mit KI“). Bei kennzeichnungspflichtigen Bildern oder Videos – etwa nicht-satirischen Deepfakes – empfiehlt sich ein Wasserzeichen.

7) Regelmäßige Prüfung

Führen Sie regelmäßige Audits durch – etwa alle sechs Monate oder bei größeren Updates von Tools, die Sie besonders intensiv nutzen.

Prüfen Sie dabei vor allem, ob sich Risikostufen geändert haben, und falls ja, was Sie unternehmen müssen, um die Compliance mit dem EU AI Act weiterhin sicherzustellen.

Wenn Sie ein Inventarisierungstool nutzen, sollten Sie alle Veränderungen natürlich auch hier protokollieren.

8) Plan für Vorfälle entwickeln

Definieren Sie eine Vorgehensweise für Compliance-Verstöße – zum Beispiel, wenn ein Mitarbeiter versehentlich personenbezogene Daten in ChatGPT hochgeladen hat. Dann müssen Sie sich fragen:

- Wie kann der Schaden begrenzt werden?

- Wer muss von dem Verstoß erfahren?

- Welche Konsequenzen haben Mitarbeiter bei einmaligen oder mehrfachen Verstößen zu erwarten?

Wenn Sie diese Fragen beantworten, bevor es überhaupt zu einem Vorfall kommt, können Sie eine faire Behandlung aller Mitarbeiter gewährleisten.

9) Alles dokumentieren

Dokumentieren Sie während der vorangegangenen Schritte systematisch alles, was dazu beiträgt, dass sich Behörden im Ernstfall ein umfassendes Bild Ihrer Bemühungen um Compliance machen können:

- Versehen Sie das Inventar und die Richtlinien mit dem Datum der letzten Revision,

- begründen Sie Risiko-Einschätzungen bei kritischen Tools,

- speichern Sie die Ergebnisse von Audits zentral ab.

Dann sind Sie immer auf der sicheren Seite und können sich wieder auf die Chancen von KI konzentrieren.

Infografik

Wir haben die 9 Schritte zur EU-AI-Act-Compliance für Sie hier in Form einer Infografik visualisiert:

Häufig gestellte Fragen zum EU AI Act

Künstliche Intelligenz ist eine vielseitige Technologie, der EU AI Act ein komplexes Regelwerk. Im Marketingalltag tauchen daher schnell Detailfragen auf. Zum Beispiel die folgenden:

Worauf muss ich beim Einsatz von ChatGPT und ähnlichen Tools achten?

Prüfen Sie, ob der Output unter die Transparenzpflicht fällt. Generell ist es eine gute Idee, den Output sorgfältig zu prüfen und umfassend zu bearbeiten, auch um die Urheberrechte zu erlangen.

Achten Sie außerdem darauf, keine sensiblen Daten einzugeben oder hochzuladen. Dazu zählen …

- personenbezogene,

- urheberrechtlich geschützte und

- vertrauliche Daten.

Zum Beispiel sollten Sie keine Kundendaten analysieren, keine Whitepaper Dritter zusammenfassen lassen und keine kritischen Forecasts diskutieren.

Muss ich alle KI-Inhalte kennzeichnen?

Nein – eine Kennzeichnung ist nur in wenigen Fällen erforderlich.

Gute Beispiele für eine Kennzeichnungspflicht sind …

- Chatbots (weil Nutzer wissen sollten, dass sie nicht mit einem Menschen sprechen),

- ungeprüfte und unbearbeitete KI-Texte über Themen von öffentlichem Interesse (weil diese irreführende Informationen enthalten können) und

- Deepfakes (weil Täuschungspotenzial besteht).

Im Allgemeinen kommt es also darauf an, ob die KI geeignet ist, Menschen zu täuschen und sie auf diese Weise in ihren Entscheidungen zu beeinflussen.

Was ist „unzulässige Manipulation“ im Marketing?

Unter dem Begriff der „unzulässigen Manipulation“ versteht der AI Act jede Form von KI-Nutzung, die gezielt Schwächen von Personen ausnutzt, um deren Verhalten zu beeinflussen.

Dazu zählen …

- unterschwellige Werbung durch KI-Assistenten,

- Emotionserkennung zur Optimierung von Verkaufsgesprächen oder

- die gezielte Ansprache älterer Menschen, um sie unter Ausnutzung von Unsicherheiten zum Kauf eines Produktes zu bewegen.

Solange Sie also, wie gewohnt, ethisches Marketing betreiben und keine dubiosen Tricks anwenden, haben Sie nichts zu befürchten.

Fazit

Die KI-Verordnung der Europäischen Union markiert einen Wendepunkt für Marketing-Teams, die künstliche Intelligenz einsetzen. Mit ihrem risikobasierten Ansatz schafft die Verordnung einen verbindlichen Rahmen, der Innovationen fördert, aber gleichzeitig klare Grenzen setzt, um die Risiken für Nutzer und Gesellschaft zu minimieren.

Für Marketer bedeutet der EU AI Act, dass sie ihre KI-Tools genau prüfen und möglicherweise Arbeitsabläufe anpassen müssen. Die Kennzeichnungspflicht für KI-generierte Inhalte und der Umgang mit sensiblen Daten sind die Punkte der Verordnung, die fürs Marketing besonders relevant sind.

Die schrittweise Einführung der Verordnung bis August 2027 gibt Unternehmen zwar etwas Zeit, doch die ersten Regelungen – wie das Verbot von KI-Systemen mit unannehmbarem Risiko – gelten bereits seit Februar 2025. Marketing-Teams sollten jetzt handeln, indem sie ihre KI-Tools inventarisieren, die jeweiligen Risiken bewerten und klare Richtlinien etablieren. Ein strukturierter Ansatz – wie die hier vorgeschlagene 9-Schritte-Checkliste – hilft dabei, die Compliance mit dem EU AI Act sicherzustellen und zu dokumentieren.

Neben diesen Herausforderungen bietet die KI-Verordnung der Europäischen Union durchaus auch Chancen: Wer die Vorgaben konsequent umsetzt und für höchste Sicherheit und Transparenz sorgt, kann gerade in der Übergangszeit, in der die neue Technologie noch auf ein hohes Maß an Skepsis stößt, das Vertrauen der Zielgruppe gewinnen.